[10] Cephadm – konfiguracja klastra #2

21 lipca 2020Zainstalujemy i skonfigurujemy teraz Klaster Ceph z [Cephadm] – jest to narzędzie do rozmieszczania i zarządzania klastrem.

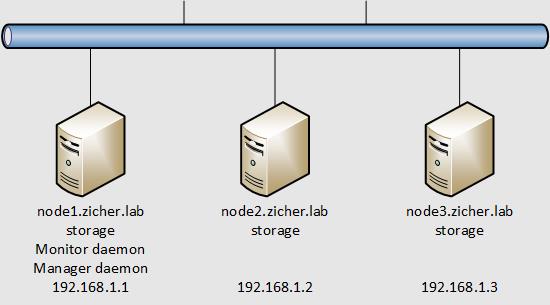

W tym przykładzie skonfigurujemy klaster Ceph z użyciem 3 węzłów, wykorzystane zostaną do przechowywania wolne urządzenia blokowe – tutaj [/dev/sdb].

Schemat sieci przedstawia się następująco.

[1] Skonfiguruj najpierw podstawowe ustawienia Cephadm.

[2] Dodaj węzły do klastra. My dodamy węzły [node2] oraz [node3].

[root@node1 ~]# ssh-copy-id -f -i /etc/ceph/ceph.pub root@node2

/usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/etc/ceph/ceph.pub"

Number of key(s) added: 1

Now try logging into the machine, with: "ssh 'root@node2'"

and check to make sure that only the key(s) you wanted were added.

[root@node1 ~]# ssh-copy-id -f -i /etc/ceph/ceph.pub root@node3

/usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/etc/ceph/ceph.pub"

Number of key(s) added: 1

Now try logging into the machine, with: "ssh 'root@node3'"

and check to make sure that only the key(s) you wanted were added.

# dodaj docelowe węzły do klastra

[root@node1 ~]# ceph orch host add node2.zicher.lab

INFO:cephadm:Inferring fsid 43af2de0-cb74-11ea-8312-000c292b8c0c

INFO:cephadm:Using recent ceph image docker.io/ceph/ceph:v15

Added host 'node2.zicher.lab'

[root@node1 ~]# ceph orch host add node3.zicher.lab

INFO:cephadm:Inferring fsid 43af2de0-cb74-11ea-8312-000c292b8c0c

INFO:cephadm:Using recent ceph image docker.io/ceph/ceph:v15

Added host 'node3.zicher.lab'

[root@node1 ~]# ceph orch host ls

INFO:cephadm:Inferring fsid 43af2de0-cb74-11ea-8312-000c292b8c0c

INFO:cephadm:Using recent ceph image docker.io/ceph/ceph:v15

HOST ADDR LABELS STATUS

node1.zicher.lab node1.zicher.lab

node2.zicher.lab node2.zicher.lab

node3.zicher.lab node3.zicher.lab

[3] Skonfiguruj OSD’y. W tym przykładzie użyjemy [node1], [node2], [node3].

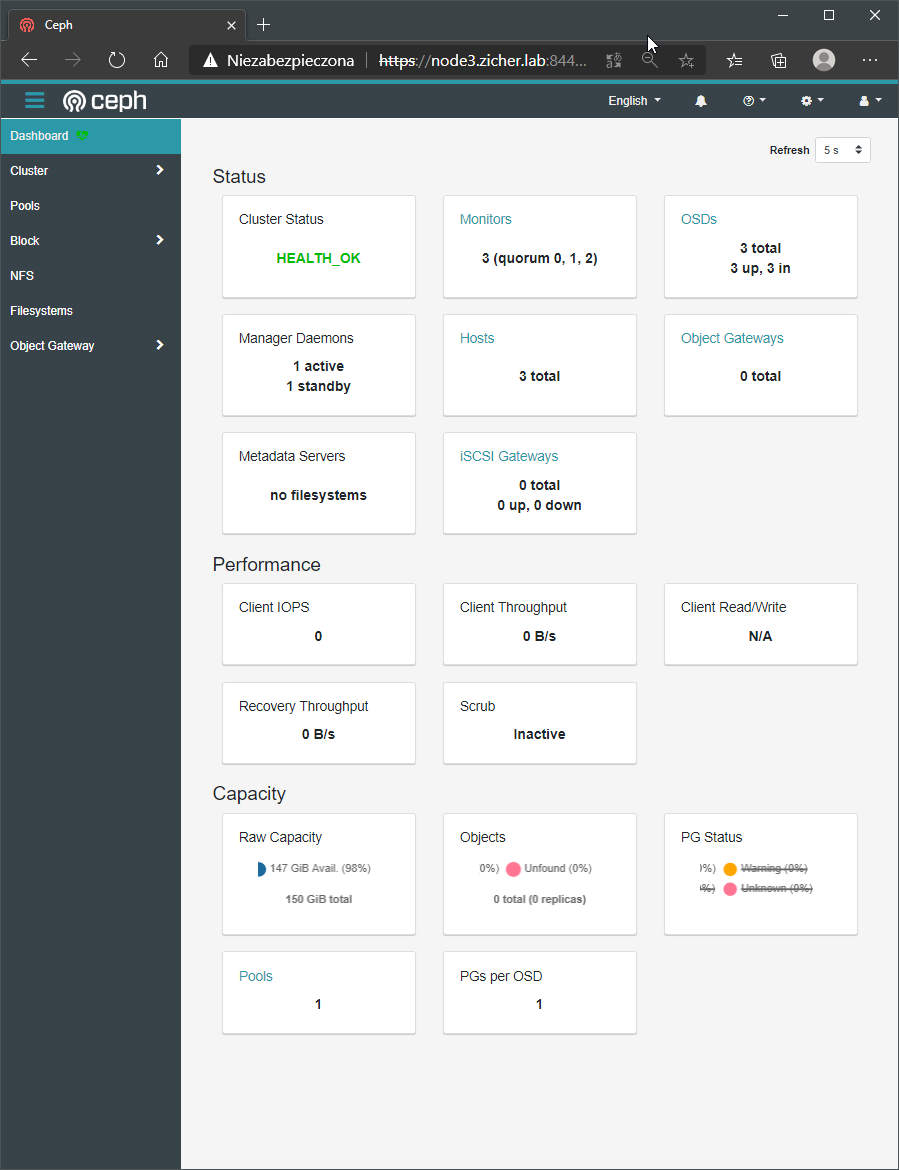

# wylistuj dostępne urządzenia # dostępne jeżeli [AVIAL = True] [root@node1 ~]# ceph orch device ls INFO:cephadm:Inferring fsid 43af2de0-cb74-11ea-8312-000c292b8c0c INFO:cephadm:Using recent ceph image docker.io/ceph/ceph:v15 HOST PATH TYPE SIZE DEVICE AVAIL REJECT REASONS node1.zicher.lab /dev/sdb hdd 50.0G True node1.zicher.lab /dev/sda hdd 100G False LVM detected, locked, Insufficient space (<5GB) on vgs node2.zicher.lab /dev/sdb hdd 50.0G True node2.zicher.lab /dev/sda hdd 100G False LVM detected, Insufficient space (<5GB) on vgs, locked node3.zicher.lab /dev/sdb hdd 50.0G True node3.zicher.lab /dev/sda hdd 100G False locked, LVM detected, Insufficient space (<5GB) on vgs # skonfiguruj OSD'y [root@node1 ~]# ceph orch daemon add osd node1.zicher.lab:/dev/sdb INFO:cephadm:Inferring fsid 43af2de0-cb74-11ea-8312-000c292b8c0c INFO:cephadm:Using recent ceph image docker.io/ceph/ceph:v15 Created osd(s) 0 on host 'node1.zicher.lab' [root@node1 ~]# ceph orch daemon add osd node2.zicher.lab:/dev/sdb INFO:cephadm:Inferring fsid 43af2de0-cb74-11ea-8312-000c292b8c0c INFO:cephadm:Using recent ceph image docker.io/ceph/ceph:v15 WARNING: The same type, major and minor should not be used for multiple devices. Created osd(s) 1 on host 'node2.zicher.lab' [root@node1 ~]# ceph orch daemon add osd node3.zicher.lab:/dev/sdb INFO:cephadm:Inferring fsid 43af2de0-cb74-11ea-8312-000c292b8c0c INFO:cephadm:Using recent ceph image docker.io/ceph/ceph:v15 WARNING: The same type, major and minor should not be used for multiple devices. Created osd(s) 2 on host 'node3.zicher.lab' # po kilku minutach status powinien zmienić się na [HEALTH_OK] [root@node1 ~]# ceph -s INFO:cephadm:Inferring fsid 43af2de0-cb74-11ea-8312-000c292b8c0c INFO:cephadm:Using recent ceph image docker.io/ceph/ceph:v15 cluster: id: 43af2de0-cb74-11ea-8312-000c292b8c0c health: HEALTH_OK services: mon: 3 daemons, quorum node1.zicher.lab,node2,node3 (age 2m) mgr: node3.mtewwb(active, since 100s), standbys: node1.zicher.lab.ntlwxo osd: 3 osds: 3 up (since 104s), 3 in (since 98m) data: pools: 1 pools, 1 pgs objects: 0 objects, 0 B usage: 3.0 GiB used, 147 GiB / 150 GiB avail pgs: 1 active+clean # jeśli jednak tak by się nie stało wykonaj poniższą komendę oraz zrestartuj węzły [root@node1 ~]# ceph auth add client.crash.node1.zicher.lab mgr "profile crash" mon "profile crash" [root@node1 ~]# ceph auth add client.crash.node2.zicher.lab mgr "profile crash" mon "profile crash" [root@node1 ~]# ceph auth add client.crash.node3.zicher.lab mgr "profile crash" mon "profile crash"

[4] Aby zarządzać/ klastrem zaloguj się na podany tutaj w [4] adres.

[5] Aby usunąć OSD wykonaj.

[root@node1 ~]# ceph osd tree INFO:cephadm:Inferring fsid 43af2de0-cb74-11ea-8312-000c292b8c0c INFO:cephadm:Using recent ceph image docker.io/ceph/ceph:v15 ID CLASS WEIGHT TYPE NAME STATUS REWEIGHT PRI-AFF -1 0.14639 root default -3 0.04880 host node1 0 hdd 0.04880 osd.0 up 1.00000 1.00000 -5 0.04880 host node2 1 hdd 0.04880 osd.1 up 1.00000 1.00000 -7 0.04880 host node3 2 hdd 0.04880 osd.2 up 1.00000 1.00000 # usuniemy teraz OSD o ID 2 [root@node1 ~]# ceph orch osd rm 2 INFO:cephadm:Inferring fsid 43af2de0-cb74-11ea-8312-000c292b8c0c INFO:cephadm:Using recent ceph image docker.io/ceph/ceph:v15 Scheduled OSD(s) for removal # zobaczmy status usuwania # jest on ukończony jeśli po tej komendzie nie pokażą się żadne wyniki # proces zajmuje dużo czasu [root@node1 ~]# ceph orch osd rm status INFO:cephadm:Inferring fsid 43af2de0-cb74-11ea-8312-000c292b8c0c INFO:cephadm:Using recent ceph image docker.io/ceph/ceph:v15 NAME HOST PGS STARTED_AT osd.2 node3.zicher.lab n/a 2020-07-21 20:06:54.012367